[vc_section][vc_row][vc_column]

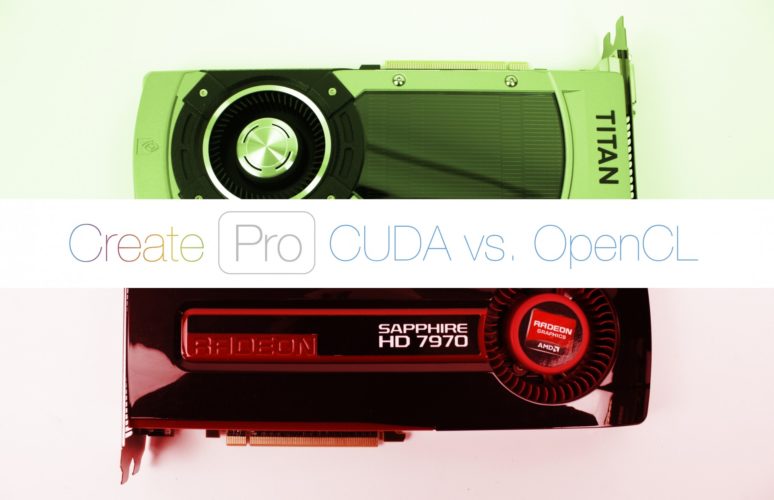

OpenCL và CUDA: Ứng dụng này tương hỗ đảm bảo chất lượng hơn?

Giới thiệu về GPGPU

Vậy đúng mực thì GPGPU là gì?

Bạn đang xem: open cl la gi

Chúng tao tiếp tục biết, GPU (graphics processing unit) là đơn vị chức năng xử lý hình đồ họa, thông thường chỉ xử lý hình đồ họa PC, nhằm tương hỗ tiến hành những tác vụ thông thường được xử lý vày CPU (central processing unit – đơn vị chức năng xử lý trung tâm).

Trong năng lượng điện toán truyền thống cuội nguồn, tài liệu hoàn toàn có thể được truyền kể từ CPU lịch sự GPU, GPU tiếp sau đó kết xuất tài liệu, đo lường hình hình họa xuất lên màn hình hiển thị (ví dụ chơi trò chơi mượt hơn) tuy nhiên GPU tự động nó ko thể giữ lại vấn đề tiếp tục xử lý mang đến CPU. Để GPU trả lại thành phẩm mang đến CPU, cần phải có sự tương hỗ của GPGPU (General Purpose Computing on Graphics Processing Units). cũng có thể nói: GPGPU đó là bộ phận nhằm GPU tiếp xúc với CPU. GPGPU được chấp nhận vấn đề được truyền hỗ tương cả nhì phía, kể từ CPU lịch sự GPU và ngược lại, kể từ GPU lịch sự CPU. Việc xử lý hai phía như thế hoàn toàn có thể nâng cao hiệu suất cao nhập thật nhiều trọng trách tương quan cho tới hình hình họa và đoạn Clip. Nếu phần mềm các bạn dùng tương hỗ OpenCL hoặc CUDA, thường thì các bạn sẽ thấy hiệu suất tăng rất rộng lớn khi dùng Hartware tương hỗ GPGPU framework với tương quan.[/vc_column_text]

Trong tình huống render bên trên VRay, Octane, Redshift, Blender,… thì cần phải có GPGPU, CPU đo lường rồi truyền thành phẩm mang đến GPU đo lường hình hình họa sau này lại trả thành phẩm về CPU. Nếu các bạn với nhiều hơn nữa 1 GPU thì khối hệ thống vẫn thao tác làm việc tuy nhiên ko cần thiết SLI hoặc CrossFireX vì thế thời điểm hiện nay những GPU thao tác làm việc song lập với nhau

Vậy giờ đây các bạn tiếp tục biết GPGPU là gì, tuy nhiên thực hiện thế này nhằm dùng OpenCL và CUDA được hợp lí nhất ? OpenCL hiện tại là GPGPU framework mã mối cung cấp banh tiên phong hàng đầu. CUDA, mặt mày không giống, là GPGPU framework độc quyền tiên phong hàng đầu.[/vc_column_text]

Vị trí của Nvidia & AMD nhập GPGPU?

Đương nhiên, thắc mắc tiếp sau của các bạn sẽ là “ứng dụng tuy nhiên tôi lựa lựa chọn với tương hỗ CUDA hoặc OpenCL không?” Hoặc “vậy, nếu như phần mềm của tôi tương hỗ cả nhì, tôi nên sử dụng loại nào?” Đừng phiền lòng, Cửa Hàng chúng tôi tiếp tục giúp đỡ bạn.

Cần Note rằng những thẻ Nvidia thực sự tương hỗ OpenCL tương đương CUDA, bọn chúng chỉ ko dẫn đến hiệu suất cao tương tự với những GPU AMD khi nói đến việc đo lường OpenCL.[/vc_column_text]

Điểm mạnh mẽ của việc bức tốc CUDA là gì?

Sự đồng thuận cộng đồng là nếu như phần mềm các bạn lựa chọn tương hỗ cả CUDA và OpenCL, hãy dùng CUDA vì thế nó sẽ bị dẫn đến thành phẩm hiệu suất đảm bảo chất lượng rộng lớn. Lý vì thế chủ yếu mang đến điều này là Nvidia cung ứng sự tương hỗ quality tiên phong hàng đầu cho những ngôi nhà cải tiến và phát triển phần mềm lựa chọn dùng bức tốc CUDA, vì thế việc tích hợp ý luôn luôn tuyệt hảo. Ví dụ: như Adobe CC, tương hỗ cả CUDA và OpenCL, CUDA tiếp tục bức tốc nhiều công dụng rộng lớn và cung ứng kỹ năng bức tốc đảm bảo chất lượng rộng lớn cho những công dụng mặc cả nhì frameworks hoàn toàn có thể cung ứng tích điện. Còn so với Premiere Pro CS6, không tồn tại CUDA thì chỉ mất kỹ năng preview dựa vào ứng dụng là chạy thuần CPU. Để hướng dẫn thêm, nhập một diễn đàn chủ thể về Creative Cow, một nhân viên cấp dưới Adobe tiếp tục bảo rằng nhập đa số những tình huống, CUDA tiếp tục đảm bảo chất lượng rộng lớn OpenCL.

Một ví dụ điển hình nổi bật không giống về sự việc khác lạ thân ái tương hỗ CUDA và OpenCL hoàn toàn có thể được bắt gặp nhập REDCINE-X. Nếu các bạn nhảy OpenCL, chỉ hoàn toàn có thể dùng 1 GPU, tuy vậy, khi CUDA được nhảy, 2 GPU hoàn toàn có thể được dùng mang đến GPGPU.

Rõ ràng, vì thế CUDA là một trong những framework độc quyền, nó yên cầu sự tương hỗ của Nvidia, và thời hạn nhằm tích hợp ý nó nhập những phần mềm, điều này Có nghĩa là tác dụng này luôn luôn trực tiếp tuyệt hảo. Tuy nhiên, CUDA ko đơn giản đồng ý những phần mềm như OpenCL (bởi vì thế OpenCL là mối cung cấp mở). Bất kể điều này, CUDA vẫn được tương hỗ vày thật nhiều phần mềm tuy nhiên list những phần mềm này vẫn tồn tại đang được nối tiếp cải tiến và phát triển.

Như một quy tắc dễ nắm bắt, nếu phần mềm của khách hàng tương hỗ CUDA, hãy sử dụng thẻ Nvidia, trong cả khi phần mềm này cũng tương hỗ OpenCL.[/vc_column_text]

Điểm mạnh mẽ của Nền tảng OpenCL là gì?

Nói một cơ hội đơn giản và giản dị, nếu OpenCL là lựa lựa chọn có một không hai của khách hàng, nên lựa chọn nó. Ví dụ: Final Cut Pro X chỉ tương hỗ OpenCL và Cửa Hàng chúng tôi thông thường khuyên răn người tiêu dùng nên sử dụng thẻ AMD OpenCL mang đến khối hệ thống của mình nếu như chúng ta dùng phần mềm sửa đổi đoạn Clip thông dụng. Trên toàn cỗ tích hợp ý OpenCL thông thường ko ngặt nghèo được như CUDA, tuy nhiên OpenCL vẫn sẽ tạo nên đi ra hiệu suất tăng đáng chú ý khi dùng và đảm bảo chất lượng rất nhiều đối với việc ko dùng GPGPU.

Như tiếp tục phát biểu trước cơ, những thẻ Nvidia cũng dùng framework OpenCL, tuy nhiên bọn chúng ko cải tiến và phát triển hiệu suất cao giống như các thẻ AMD (tuy nhiên, bọn chúng đang được đuổi theo kịp đặc biệt nhanh). Vì vậy, nếu như những phần mềm các bạn dùng trọn vẹn dựa vào OpenCL và không tồn tại tương hỗ CUDA, ví dụ như Final Cut Pro X, Cửa Hàng chúng tôi khuyên răn chúng ta nên chuẩn bị mang đến khối hệ thống của tớ một GPU AMD OpenCL.[/vc_column_text]

Một số phần mềm của tôi dựa vào CUDA và một trong những chỉ việc tương hỗ OpenCL. Tôi nên thực hiện gì?

Ví dụ, GPU Nvidia GTX 980 đạt 2600 điểm nhập LuxMark Sala (Điểm chuẩn chỉnh OpenCL), cao hơn nữa AMD R9 280X (đạt 2400 điểm). Nếu các bạn dùng Adobe CC hoặc những phần mềm được tương hỗ CUDA không giống, tương đương ứng dụng độc quyền OpenCL như Final Cut Pro X, Nvidia GTX 780 và 980, đều là những biện pháp vững chãi.[/vc_column_text]

Ứng dụng này tương hỗ GPGPU Framework nào?

· Adobe After Effects CC

CUDA tư vấn, 3 chiều ray tracing, Multi GPU support

OpenCL support: Có tương hỗ tuy nhiên AMD ko công tía vấn đề chi tiết

· Adobe Photoshop CC

CUDA Support, 30 effects in Mercury Graphics Engine

OpenCL Support Có tương hỗ tuy nhiên AMD ko công tía vấn đề chi tiết

· Adobe Premiere Pro CC

CUDA Support, Mercury Playback Engine mang đến real-time đoạn Clip editing & bức tốc rendering

OpenCL Support Có tương hỗ tuy nhiên AMD ko công tía vấn đề chi tiết

· Adobe SpeedGrade CC

CUDA Support, Real-time grading and finishing

OpenCL ko hỗ trợ

· Autodesk Maya

CUDA Support, Increased model complexity, Larger scenes

OpenCL Support Physics simulations

· Avid Media Composer

CUDA Support Faster đoạn Clip effects Unique stereo 3 chiều capabilities

OpenCL ko hỗ trợ

· Avid Motion Graphics

CUDA Support Real-time rendering

Xem thêm: Bí quyết xem trực tiếp bóng đá miễn phí, chất lượng hiện nay

OpenCL ko hỗ trợ

· Blackmagic DaVinci Resolve

CUDA Support Real-time colour correction Real-time de-noising

OpenCL Support Real-time colour correction

· Final Cut Pro X

OpenCL Support Real-time FX editing – no need to tát render the timeline Faster overall playback & timeline performance Faster third-party effect rendering No transcoding of AVCHD or other complex codecs to tát editable ProRes

· RED REDCINE-X

CUDA Support Accelerated debayering

Decoding đoạn Clip upto 8K Hỗ trợ mang đến 2 GPUs

OpenCL Support Có tương hỗ tuy nhiên AMD ko công tía vấn đề chi tiết Chỉ tương hỗ 1 GPU

· RED Giant Effects Suite

CUDA Support Faster effects

OpenCL ko hỗ trợ

· RED Giant Magic Bullet Looks

CUDA Support Faster effects

OpenCL ko hỗ trợ

· SONY Vegas Pro

CUDA Support Faster đoạn Clip effects and encoding

OpenCL Support Có tương hỗ tuy nhiên AMD ko công tía vấn đề chi tiết

· The Foundry HIERO

CUDA Support Better interactivity

OpenCL ko hỗ trợ

· The Foundry NUKE & NUKEX

CUDA Support Faster effects

OpenCL ko hỗ trợ

· The Foundry Mari

CUDA Support Increased model complexity at interactive rates

OpenCL ko hỗ trợ[/vc_column_text]

Kết luận

Hiện bên trên CUDA và OpenCL là những GPGPU framework tiên phong hàng đầu. CUDA là một trong những Nvidia framework độc quyền, nó ko được tương hỗ trong không ít phần mềm như OpenCL (tuy nhiên tương hỗ vẫn tồn tại khá rộng), tuy nhiên được tích hợp ý tương hỗ Nvidia quality tiên phong hàng đầu đáp ứng tính năng tuyệt hảo. OpenCL là mã mối cung cấp banh và được tương hỗ trong không ít phần mềm rộng lớn CUDA. Tuy nhiên, tương hỗ thông thường ko rõ rệt và thời điểm hiện tại nó ko cung ứng những nấc tăng hiệu suất tương tự động tuy nhiên CUDA với.

Theo ý kiến của Cửa Hàng chúng tôi, GPU Nvidia (đặc biệt là những GPU sau này) thông thường là lựa lựa chọn rất tốt cho những người dùng, được tích hợp ý tương hỗ CUDA tương đương tính năng OpenCL uy lực khi CUDA ko được tương hỗ. Tình huống có một không hai tuy nhiên Cửa Hàng chúng tôi ham muốn trình làng GPU AMD cho những Chuyên Viên là lúc chúng ta độc quyền dùng những phần mềm tương hỗ OpenCL và không tồn tại tùy lựa chọn CUDA.[/vc_column_text]

Render thì ko cần thiết SLI hoặc CrossFireX tuy nhiên CPU cũng cần mạnh

Máy moi bitcoin với render được không? Có render được tuy nhiên sẽ ảnh hưởng biểu hiện nghẽn cổ chai nếu như CPU ko đầy đủ mạnh

Xem thêm: quân thiếu cưng chiều cô vợ thiên hậu

Chọn AMD hoặc Nvidia? nó tùy thuộc vào ứng dụng các bạn đang được dùng. Nếu các bạn sử dụng ứng dụng chỉ tương hỗ OpenCL thì nên lựa chọn AMD. Nếu ứng dụng tương hỗ cả hai thì lựa chọn Nvidia. Nếu sử dụng Blender Cycles, Octane, Redshift, VRay nhằm render thì nên lựa chọn Nvidia. trái lại nếu như bạn render vày LuxCoreRender 9 hoặc Radeon ProRender 17 thì lựa chọn AMD.

Còn, nếu như bạn vẫn tồn tại lưỡng lự chưa chắc chắn nên lựa chọn như này. Vậy thì hoặc chớ ngần quan ngại ĐK thông tin tài khoản bên trên trên đây nhằm dùng cty của iRender, nhanh gọn, đơn giản và giản dị và hiệu quả![/vc_column_text][vc_column_text]

Nguồn: Lược dịch vày iRender

[/vc_column_text][vc_separator][/vc_column][/vc_row][/vc_section]

Bình luận